Czy interfejs mózg-komputer może przekształcać myśli na tekst?

Zastanawialiście się kiedyś co by było, gdyby urządzenia mogły odgadywać myśli jeszcze przed wypowiedzeniem lub napisaniem zdania? Tymczasem nie tylko poprawiłoby to zdolności istniejących już połączeń mowy z innymi urządzeniami, ale również byłoby to rozwiązaniem dla osób z zaburzeniami mówienia, a tym bardziej dla zamkniętych w sobie pacjentów, którzy nie mówią lub wykazują brak funkcji motorycznych.

Dlatego też zamiast mówić: „Siri jak dzisiaj wygląda pogoda?” lub „Google, gdzie mogę pójść na lunch?”, mogę wyobrazić sobie wypowiadanie tych rzeczy – wyjaśnia Christian Herff, autor niedawno opublikowanej recenzji w czasopiśmie Frontiers in Human Neuroscience.

Podczas gdy czytanie myśli nadal należy do sfery science fiction, naukowcy są gotowi rozszyfrować mowę z sygnałów generowanych przez nasz mózg, kiedy mówimy bądź słuchamy mowy.

W swoim przeglądzie Herff i dr Tanja Schultz porównują plusy i minusy używania rozmaitych technik obrazowania mózgu do zawładnięcia sygnałami neuronowymi i późniejszego przekształcania ich na tekst.

Technologie te obejmują funkcjonalne obrazowanie MRI – od podczerwieni, która wykrywa neuronowe sygnały oparte na metabolicznej aktywności komórek nerwowych, do metod takich jak EEG i magnetoencefalografii (MEG) wykrywającej elektromagnetyczną aktywność neuronów reagujących na mowę. Jedną z najbardziej szczególnych metod jest elektrokortykografia (ECoG). Pokazuje ona obiecujące zastosowanie w badaniu Herff’a.

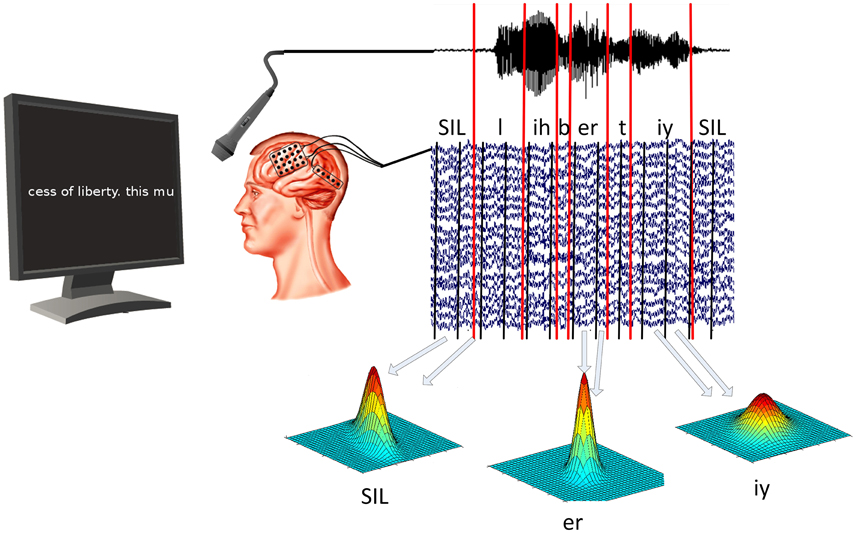

Badanie przedstawia wykorzystanie systemu konwertowania sygnałów mózgu na tekst u ludzi cierpiących na padaczkę, którzy mieli wszczepione siatki elektrod potrzebne do leczenia ich choroby. Czytali tekst prezentowany na ekranie, podczas gdy nagrywana była aktywność ich mózgu. Te doświadczenie stanowiło podstawę dla bazy wzorców sygnałów nerwowych, które można było następne dopasować do wzorców mowy.

Badacze zaimplementowali modele języka i słownika w swoim algorytmie, dzięki czemu byli oni w stanie dekodować sygnały nerwowe z tekstu z dużą dokładnością. Po raz pierwszy możemy pokazać, że aktywność mózgu może być rozszyfrowywana wystarczająco szczegółowo przy wykorzystaniu technologii ASR dla sygnałów mózgu – komentuje Herff. Jednak potrzeba wszczepionych elektrod czyni go wysoce niepraktycznym sposobem do używania w codziennym życiu.

Więc gdzie możemy używać detektora myśli tak, aby był funkcjonalny?

Pierwszym kamieniem milowym byłoby właściwe zdekodowanie fraz ukazujących się w mózgu podczas myślenia o nich, ale do tego wiele kwestii technicznych wymaga rozwiązania – przyznaje Herff.

Tłumaczenie: Dagmara Wąchocka

Źródło tekstu i obrazu: Srividya Sundaresan – Frontiers Blog

Oryginalne źródło: Otwarty dostęp; Herff C., Schultz T. (2016). Automatic Speech Recognition from Neural Signals: A Focused Review. Front. Neurosci. 10:429. doi: 10.3389/fnins.2016.00429